傳感器技術(shù)的顯著進(jìn)步使得獲取同一場(chǎng)景的多模態(tài)圖像成為可能。然而,受傳感器成像機(jī)制和復(fù)雜地面環(huán)境的影響,單模圖像往往不能提供足夠詳細(xì)的場(chǎng)景信息。例如,熱紅外圖像包含來自物體的熱輻射信號(hào),因此在可見光譜之外提供了額外的信息,但紋理信息較弱。合成孔徑雷達(dá)(SAR)圖像具有豐富的地物極化信息,且不受云層覆蓋的影響,但嚴(yán)重缺乏細(xì)節(jié)信息。與紅外和SAR數(shù)據(jù)相比,可見光圖像雖然提供了大量的紋理細(xì)節(jié),但極易受到天氣和光照變化的影響。因此,多模態(tài)圖像融合對(duì)于同時(shí)彌補(bǔ)單模傳感器的內(nèi)容或細(xì)節(jié)不足,增強(qiáng)圖像提供的信息具有重要意義。

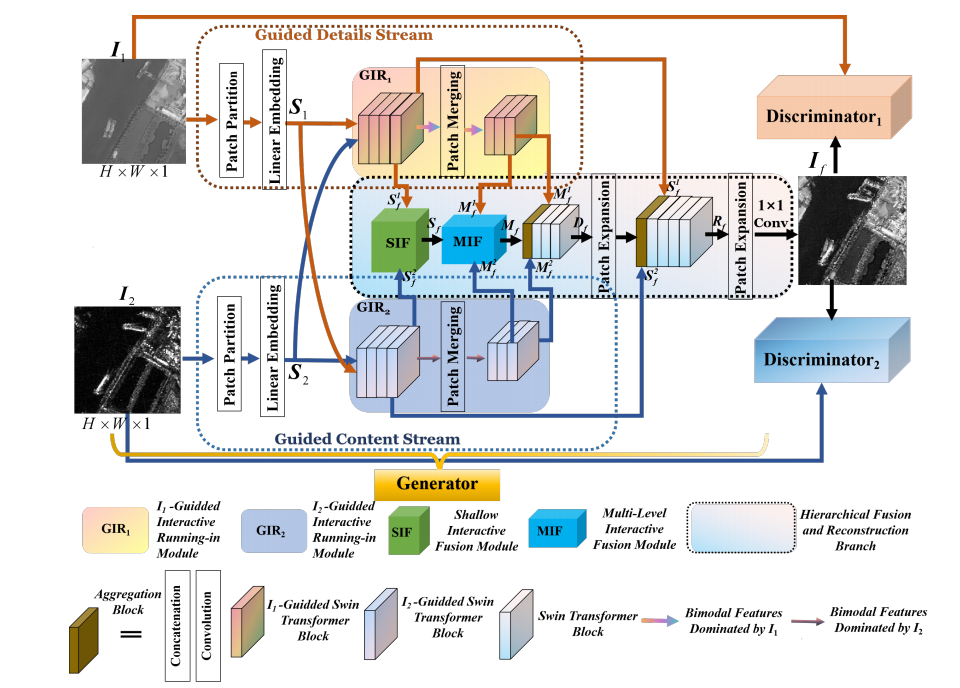

基于此,煙臺(tái)大學(xué)隋晨紅副教授的多模態(tài)遙感智能感知與認(rèn)知團(tuán)隊(duì)設(shè)計(jì)開發(fā)了一種新的交互式引導(dǎo)生成對(duì)抗網(wǎng)絡(luò),稱為IG-GAN,用于多模態(tài)圖像融合任務(wù)。IG-GAN包括為增強(qiáng)細(xì)節(jié)和內(nèi)容的學(xué)習(xí)以及跨模態(tài)一致性量身定制的引導(dǎo)雙流。此外,為了使融合網(wǎng)絡(luò)能夠在沒有監(jiān)督的情況下生成內(nèi)容完整、邊緣銳利、保真度高的融合圖像,還建立了一個(gè)損失函數(shù),便于生成器和兩個(gè)鑒別器之間相互博弈。結(jié)果表明,IG-GAN可以通過整合不同模態(tài)的互補(bǔ)信息來提高目標(biāo)檢測(cè)的精度。

相關(guān)工作以“IG-GAN: Interactive Guided Generative Adversarial Networks for Multimodal Image Fusion” 為題發(fā)表在期刊《IEEE Transactions on Geoscience and Remote Sensing》(影響因子8.2)上。該工作第一作者為隋晨紅副教授,第二作者是物理與電子信息學(xué)院2020級(jí)碩士研究生楊國彬。該工作受到了國家重點(diǎn)研發(fā)計(jì)劃項(xiàng)目、國家自然科學(xué)基金項(xiàng)目和中國博士后科學(xué)基金項(xiàng)目的資助。

來稿時(shí)間:9月13日 審核:劉希斌 責(zé)任編輯:安興爽